集群上并行测试OpenFOAM,并行效率并没有比单节点提升

-

@sjlouie91

硬盘的读写只有刚开始和写结果的时候进行,迭代过程是不做硬盘读写的,除非频繁大量进行结果的存储,不然一般硬盘不太影响计算性能,更多受CPU的cache和内存影响。

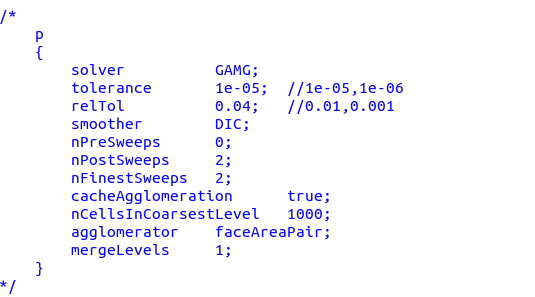

至于GAMG的参数,我选择抄

PETSc4FOAM: a library to plug-in PETSc into the OpenFOAM framework

里面提到的。 -

@李东岳 在 集群上并行测试OpenFOAM,并行效率并没有比单节点提升 中说:

-genv FI_PROVIDER tcp你这个去掉不能跑的话。你如何确定走的是infiniband,而不是以太网模式。我们这面跑openfoam不需要这个参数。我们之前测试也出现过你这种情况。后来我们换交换机硬件了。但目前我还不确定现在我们这5节点能到什么样,得下周能出个测试结果。另外,openfoam离散设置差异(比如GAMG那个),我个人感觉不会引起特别大的差异。不过你可以实测看看,我也不100%确定@xpqiu 这位大佬之前好像测试过2048个核心

老师,想问一下,用openmpi在自己组里面的集群上用pbs跨节点并行(10g以太网交换机)命令用的mpirun --mca btl_tcp_if_include <ip地址> -np reactingTwoPhaseEulerFoam -parallel,运行的时候发现计算的节点上cpu的用户进程占比us只有50-60%,系统进程占比sy有40-50%,这个问题有没有什么好的解决办法?

-

@李东岳 李老师,我们组集群是新买的,应该不太可能是被黑了,除非是大厂他们给加了限制。现在我导给换了100G的IB交换机,就是运行案例的时候,它虽然显示是在run的,但是log文件里面没有实际的计算结果。我看了调度系统的日志说是:

Open MPI accepted a TCP connection from what appears to be an another Open MPI process but cannot find a corresponding process entry for that peer.

暂时还在寻找原因。