万兆网卡两机直连

万兆网卡两机直连

@firejet CFD计算一般只看物理核心数,所以工作站最多可以设置64核,一般则会设置少一点,比如60核/56核。4条内存应该也基本满足计算需求了。你的操作系统是什么系统?还有就是工作站上没有其他任务吧?要是有时间可以把fluent启动界面贴上来一块儿研究一下。

PS:我配置工作站的时候喜欢把内存通道配满,这样就不会因为内存带宽是瓶颈影响计算速度了。

@李东岳 我是今天浏览fluent板块才看到这个问题,可能....关注具体计算速度的人不多?

@李东岳 不敢当不敢当,当时自己搭集群的时候,测试多节点并行效率经常参考这个计算时间。期待李老师的机架式服务器上线,可惜囊中羞涩,【哭(╥_╥)】。

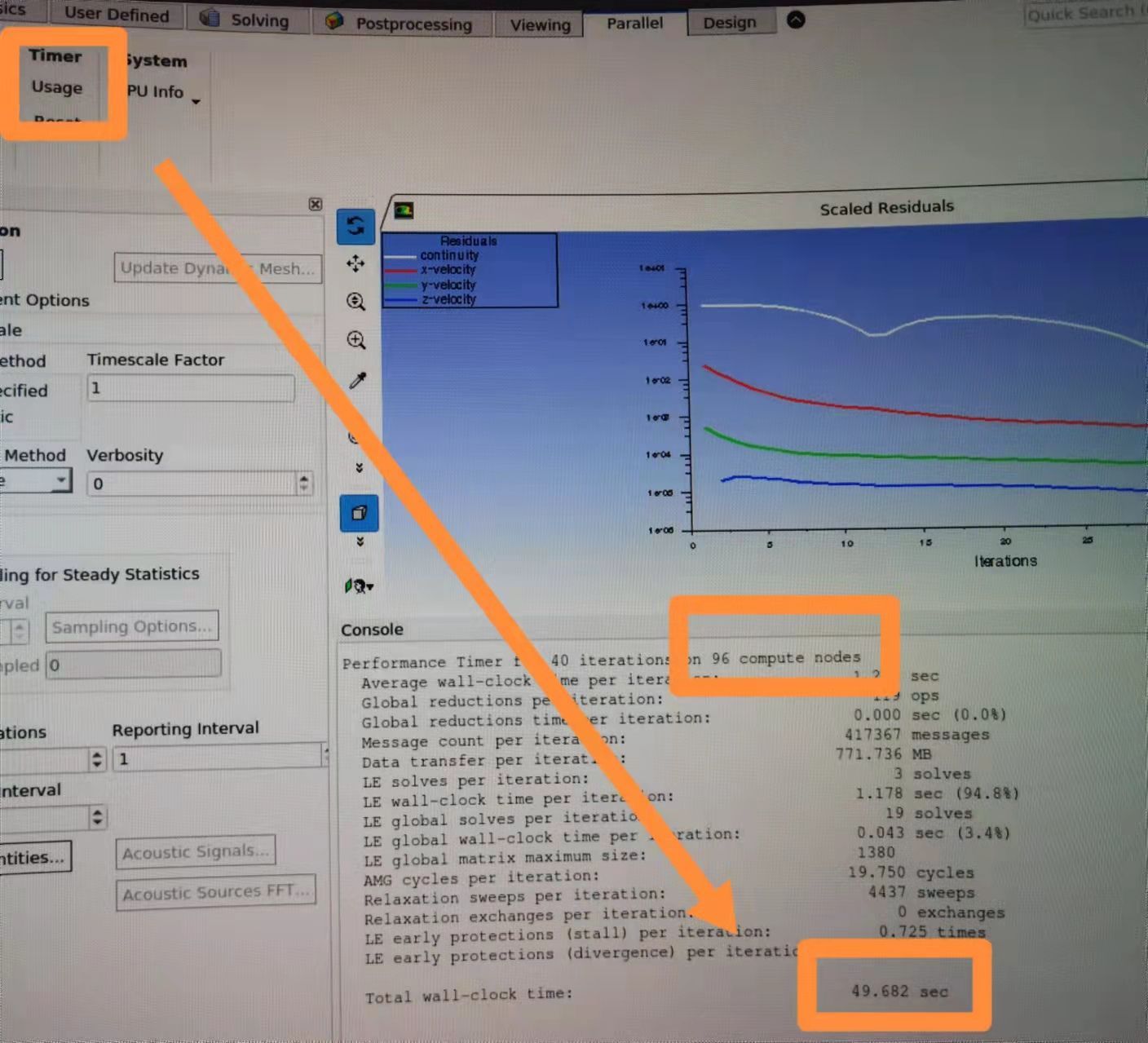

@李东岳 在Parallel里面点击usage,fluent会显示计算的总时间、计算的核心数等数据。秒表计时51s,fluent显示49.6s(96核,双机),忽略手动计时误差,基本显示是准的。

@firejet 一个CPU建议留几个核给系统,如果工作站是单CPU的话,可以试试关闭超线程,开60核或者56核。

@firejet 建议看一下你的工作站内存条插了几条,内存条少了内存带宽不足会影响性能。理论上来说这个CPU可以有8通道,两个CPU可以插16根内存条,使内存带宽最大。

@huningdong 您的和另外一个6133的数据比起来,您的计算速度更快,可能是您把内存通道配满了吧? 至于32核和40核的结果,我觉得确实有可能是因为内存带宽跑满了,不过也不排除进程多了后进程间通信拖累?

补充一下我的数据:

CPU型号:E5-2680V3,双路,8x8G DDR4-2133内存

系统:linux系统

OpenFOAM版本:OpenFOAM-8

24 139.36

16 168.45

8 196.13

4 352.66

2 648.47

1 1274.33

CPU型号:E5-2680V2,双路,8x8G DDR3-1600内存

系统:linux系统

OpenFOAM版本:OpenFOAM-8

20 180.27

16 198.1

8 204.31

4 350.34

2 615.33

1 1145.8

@东岳 是不是把内存配置也写上更容易比较?6133的结果看起来应该是内存条数量不一样

CPU型号:E5-2680V3

系统:linux系统

OpenFOAM版本:OpenFOAM-8

16 168.45

8 196.13

4 352.66

2 648.47

1 1274.33

CPU型号:E5-2680V2

系统:linux系统

OpenFOAM版本:OpenFOAM-8

16 198.1

8 204.31

4 350.34

2 615.33

1 1145.8

并行数量不能超过物理核心数,是不是要预留一定的核心给系统进程?