服务器卡死关机重启后不能并行

-

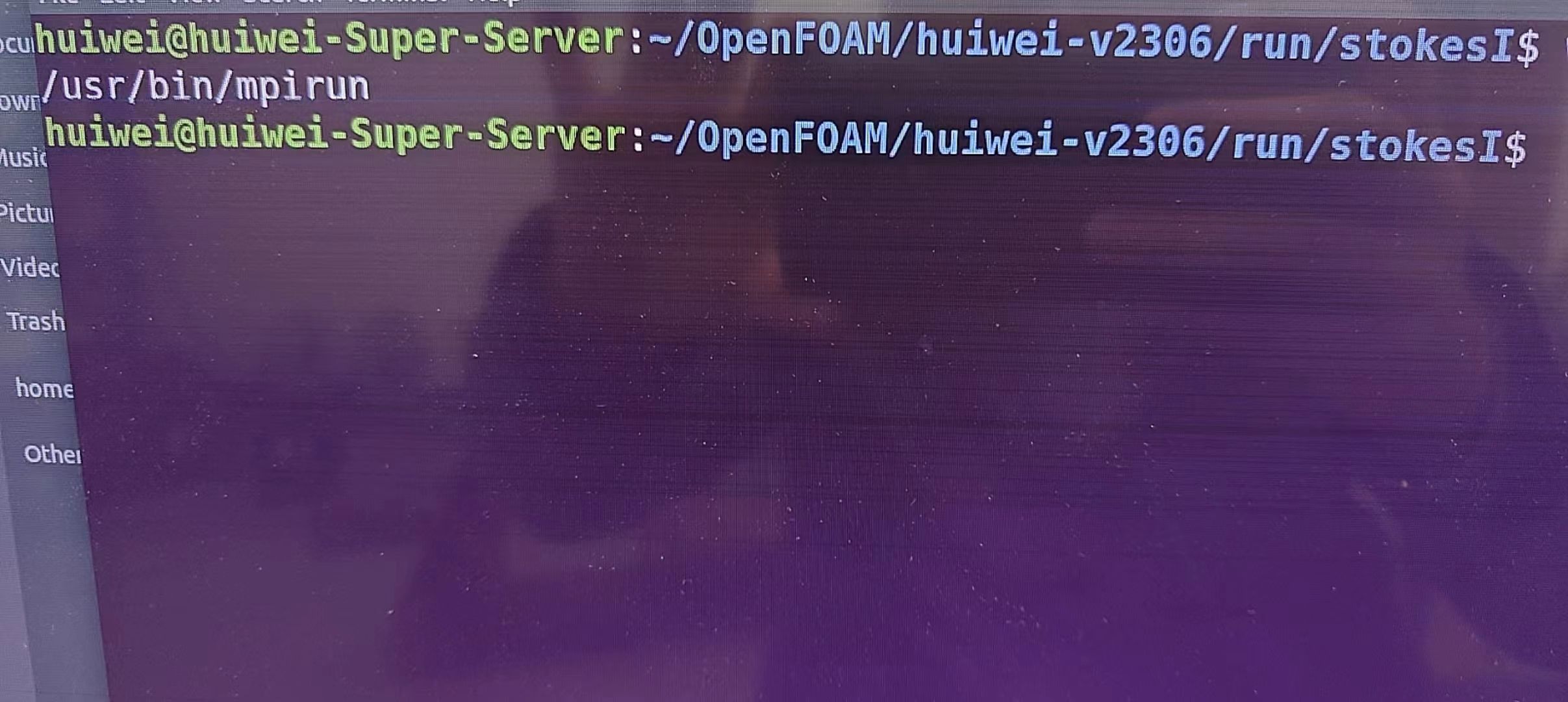

各位前辈,服务器是一个双核的机器,今天卡住了,重启后发现并行不能算了,之前卡死是因为重构并行数据的时候用cfdonline的那个方法的时候核数设置多了,然后就卡住了,算例的报错文件如下

[huiwei-Super-Server:13717] *** Process received signal *** [huiwei-Super-Server:13717] Signal: Segmentation fault (11) [huiwei-Super-Server:13717] Signal code: (128) [huiwei-Super-Server:13717] Failing at address: (nil) [huiwei-Super-Server:13718] *** Process received signal *** [huiwei-Super-Server:13718] Signal: Segmentation fault (11) [huiwei-Super-Server:13718] Signal code: (128) [huiwei-Super-Server:13718] Failing at address: (nil) [huiwei-Super-Server:13718] [ 0] /lib/x86_64-linux-gnu/libpthread.so.0(+0x12980)[0x7f800f190980] [huiwei-Super-Server:13718] [ 1] /usr/lib/x86_64-linux-gnu/openmpi/lib/openmpi/mca_pmix_pmix112.so(PMIx_Init+0x13f)[0x7f80069e7d3f] [huiwei-Super-Server:13718] [ 2] /usr/lib/x86_64-linux-gnu/openmpi/lib/openmpi/mca_pmix_pmix112.so(pmix1_client_init+0x75)[0x7f80069bbcb5] [huiwei-Super-Server:13718] [ 3] /usr/lib/x86_64-linux-gnu/openmpi/lib/openmpi/mca_ess_singleton.so(+0x2474)[0x7f8007433474] [huiwei-Super-Server:13718] [ 4] /usr/lib/x86_64-linux-gnu/libopen-rte.so.20(orte_init+0x22e)[0x7f8008fe91de] [huiwei-Super-Server:13718] [ 5] /usr/lib/x86_64-linux-gnu/libmpi.so.20(ompi_mpi_init+0x30e)[0x7f800a56027e] [huiwei-Super-Server:13718] [ 6] /usr/lib/x86_64-linux-gnu/libmpi.so.20(PMPI_Init_thread+0x45)[0x7f800a581405] [huiwei-Super-Server:13718] [ 7] /usr/lib/openfoam/openfoam2306/platforms/linux64GccDPInt32Opt/lib/sys-openmpi/libPstream.so(_ZN4Foam8UPstream4initERiRPPcb+0x98)[0x7f800eb6c478] [huiwei-Super-Server:13718] [ 8] [huiwei-Super-Server:13717] [ 0] /lib/x86_64-linux-gnu/libpthread.so.0(+0x12980)[0x7f7752fee980] [huiwei-Super-Server:13717] [ 1] /usr/lib/x86_64-linux-gnu/openmpi/lib/openmpi/mca_pmix_pmix112.so(PMIx_Init+0x13f)[0x7f774a845d3f] [huiwei-Super-Server:13717] [ 2] /usr/lib/x86_64-linux-gnu/openmpi/lib/openmpi/mca_pmix_pmix112.so(pmix1_client_init+0x75)[0x7f774a819cb5] [huiwei-Super-Server:13717] [ 3] /usr/lib/x86_64-linux-gnu/openmpi/lib/openmpi/mca_ess_singleton.so(+0x2474)[0x7f774b291474] [huiwei-Super-Server:13717] [ 4] /usr/lib/x86_64-linux-gnu/libopen-rte.so.20(orte_init+0x22e)[0x7f774ce471de] [huiwei-Super-Server:13717] [ 5] /usr/lib/x86_64-linux-gnu/libmpi.so.20(ompi_mpi_init+0x30e)[0x7f774e3be27e] [huiwei-Super-Server:13717] [ 6] /usr/lib/x86_64-linux-gnu/libmpi.so.20(PMPI_Init_thread+0x45)[0x7f774e3df405] [huiwei-Super-Server:13717] [ 7] /usr/lib/openfoam/openfoam2306/platforms/linux64GccDPInt32Opt/lib/sys-openmpi/libPstream.so(_ZN4Foam8UPstream4initERiRPPcb+0x98)[0x7f77529ca478] [huiwei-Super-Server:13717] [ 8] /usr/lib/openfoam/openfoam2306/platforms/linux64GccDPInt32Opt/lib/libOpenFOAM.so(_ZN4Foam7argListC1ERiRPPcbbb+0x310)[0x7f80102e45e0] [huiwei-Super-Server:13718] [ 9] interFoam(+0x46a8c)[0x562be93c6a8c] [huiwei-Super-Server:13718] [10] /lib/x86_64-linux-gnu/libc.so.6(__libc_start_main+0xe7)[0x7f800edaec87] [huiwei-Super-Server:13718] [11] interFoam(+0x54f4a/usr/lib/openfoam/openfoam2306/platforms/linux64GccDPInt32Opt/lib/libOpenFOAM.so(_ZN4Foam7argListC1ERiRPPcbbb+0x310)[0x7f77541425e0] [huiwei-Super-Server:13717] [ 9] interFoam(+0x46a8c)[0x5650b4393a8c] [huiwei-Super-Server:13717] [10] /lib/x86_64-linux-gnu/libc.so.6(__libc_start_main+0xe7)[0x7f7752c0cc87] [huiwei-Super-Server:13717] [11] interFoam(+0x54f4a)[0x5650b43a1f4a] [huiwei-Super-Server:13717] *** End of error message *** )[0x562be93d4f4a] [huiwei-Super-Server:13718] *** End of error message *** -------------------------------------------------------------------------- prterun noticed that process rank 0 with PID 0 on node huiwei-Super-Server exited on signal 11 (Segmentation fault). --------------------------------------------------------------------------